GauU-Scene V2 论文解读

论文:

GauU-Scene V2: Assessing the Reliability of Image-Based Metrics with Expansive Lidar Image Dataset Using 3DGS and NeRF

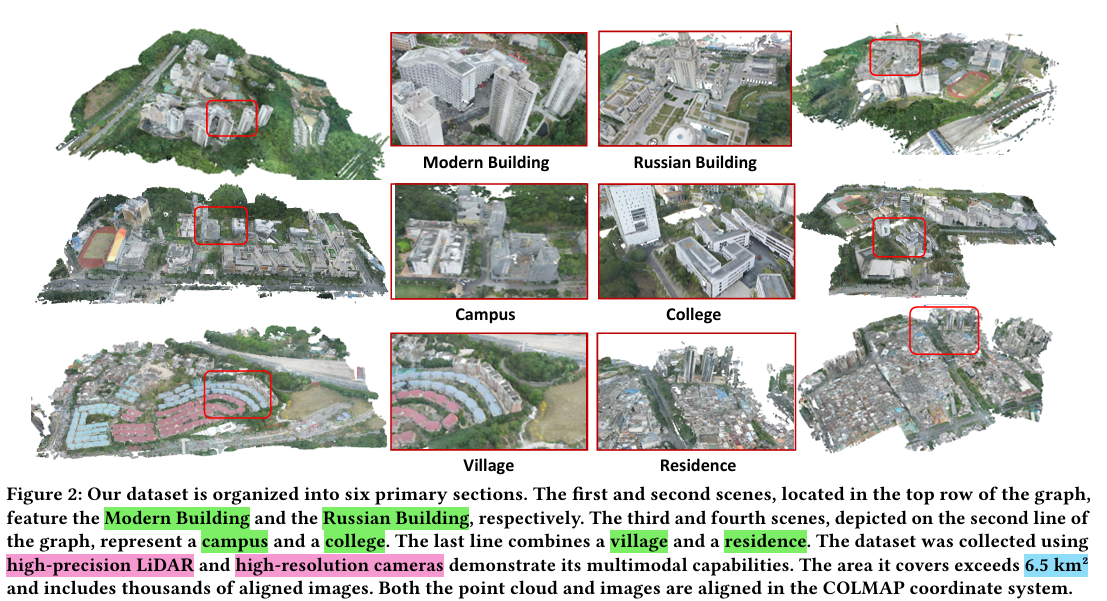

数据集

| 方法 | 做法 | 缺点 |

|---|---|---|

| bungeenerf | 卫星捕获图像 | 时间差异、无地面实况 |

| KITTI | 汽车雷达捕获点云数据 | 屋顶、高层建筑捕获存在不足 |

| blockNeRF | Style Transformation解决时间差异 | 不提供公开可用的点云数据集 |

| UrbanBIS | 多视图相机捕获点云 | 未用高精度激光雷达 |

| Urbanscene3D | 无人机配合激光雷达 | 坐标差异,雷达点云和图像关系不明确 |

优势:

- 利用Zenmuse L1来获取地面真实几何,而大多数数据集( blocknerf )( megaNeRF )( UrbanBIS )依赖单目或多视图相机进行数据采集,这更适合新视图合成而不是场景重建。

- 提供了城市规模的信息,包括高层建筑、湖泊、山脉和屋顶,而其他数据集很少提供。

- double-return技术,去除移动物体,确保更稳定的光照效果。

- 去除飞行路线中连续图像之间的冗余信息,图像更少,但信息量仍然具有可比性。

评估指标

PSNR

PSNR(Peak signal-to-noise ratio 峰值信噪比) 用于表示信号的最大可能功率与影响其表示的保真度的破坏噪声的功率之间的比率,通常使用分贝标度表示为对数量。

SSIM

SSIM全称为Structural Similarity,即结构相似性。算法会提取以下三个特征。

- 亮度

- 对比度

- 结构

亮度的估计与平均灰度有关:

对比度的估计则用标准差衡量:

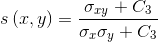

结构比较是通过使用一个合并公式来完成。

三个对比函数分别如下:

| 公式 | |

|---|---|

| 亮度 |  |

| 对比度 |  |

| 结构 |  其中 其中 |

结合即得到SSIM函数:

LPIPS

学习感知图像块相似度(Learned Perceptual Image Patch Similarity, LPIPS),通过深度学习模型来评估两个图像之间的感知差异。使用预训练的深度网络(如 VGG、AlexNet)来提取图像特征,然后计算这些特征之间的距离,以评估图像之间的感知相似度。

图示是将左右两幅图像与中间图像对比的结果。可以看到,传统方法(L2/PSNR, SSIM, FSIM)的结果与人的感知相反。而后三行通过神经网络提取特征的方法,能更符合人的感知,来评判图片的相似度。

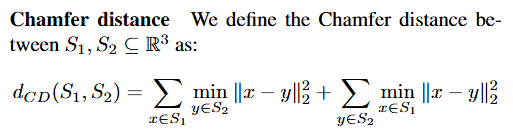

倒角距离

出自:

H. Fan, S. Hao, and L. Guibas, “A point set generation network for 3D object reconstruction from a single image,” CVPR, 2017.

算法:

- 对S1中任意一点x,计算它与S2中所有点的距离,取最小距离的平方。

- 遍历S1中的点,重复1中过程,求和所有距离平方。

- 同样的步骤,对S2中所有点遍历,重复1、2过程。

- 将两个求和结果相加,作为倒角距离。

倒角距离用于衡量两个点云之间的相似度。如果该距离较大,则说明两组点云区别较大;如果距离较小,则说明重建效果较好。

实验

实验环境

- Vanilla Gaussian Splatting: RTX 3090 * 1

- NeRF-based models: RTX 3090 * 4

实验结果

- 3DGS和SuGaR在图像的渲染中,有更优的效果(三个参数都更优),且训练时间更短。

- NeRF: 使用ns-export生成3D点云。

- 3DGS: 每个Gaussian Splatting的均值作为一个点,输出点云。

- 神经辐射场生成的点云,通常包含很多与场景无关的异常值。

- 3DGS也存在边缘效应,边缘会模糊。

(图源项目网址:GauU-Scene)

- NeRFacto,虽然在图像生成得分最低,但是倒角距离最小。而Instant-NGP和SuGaR分别是倒数第一和倒数第二。这一实验结果揭示了基于图像的测量无法代表底层几何结构的基本事实。

- SuGaR 是一种专为几何对齐设计的方法,排名却倒数。再对SuGaR进行定量分析,发现SuGaR在几何重建方面确实有更好的表现。

图中的蓝点在其他方法中很常见,而绿色甚至略带红色的点在其他方法中却很少见。更何况SuGaR中绿色点如此之多。 从定量的角度来看,如果我们忽略这里显示的异常值,SuGaR 的确是最好的方法。

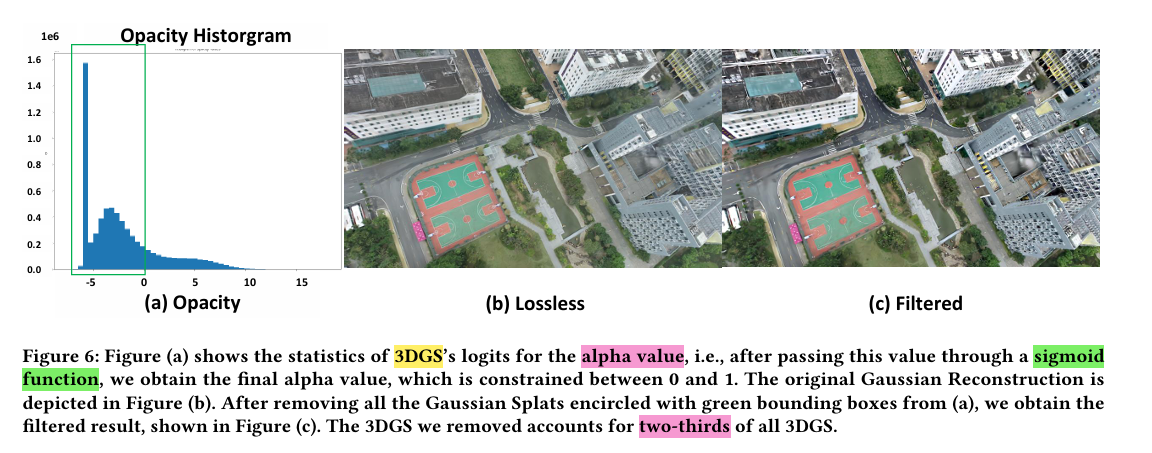

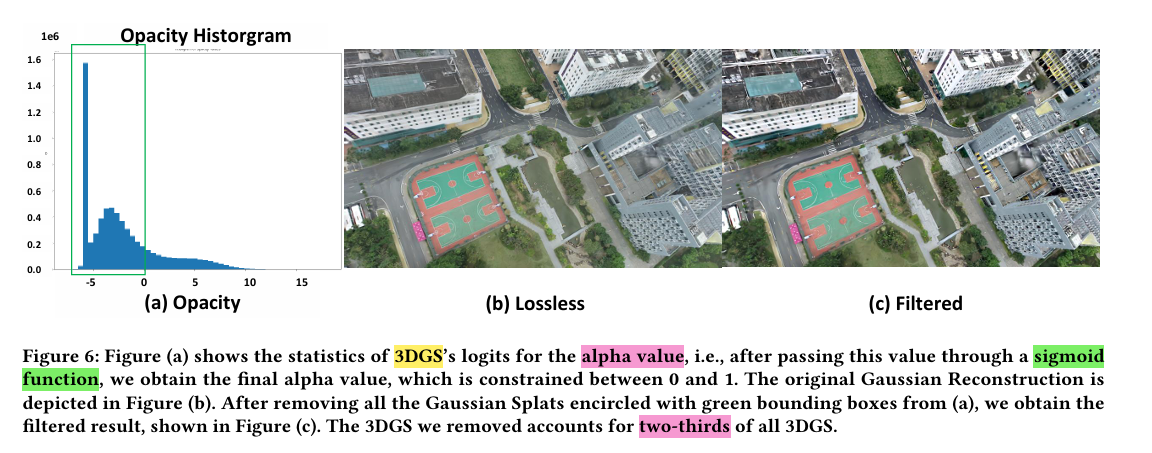

对高斯泼溅的alpha值进行了简单分析,其中几乎三分之二的alpha值几乎是透明的。通过删除这些值,渲染的图像变得更加清晰,几乎没有信息丢失。这些近乎透明的高斯飞溅实例漂浮在3D空间中。尽管它们在渲染图像中看不到,但它们会导致几何测量指标的退化。

- 标题: GauU-Scene V2 论文解读

- 作者: Felix Christian

- 创建于 : 2024-11-05 19:36:00

- 更新于 : 2025-02-25 23:46:17

- 链接: https://felixchristian.top/2024/11/05/05-GauU_Scene_V2/

- 版权声明: 本文章采用 CC BY-NC-SA 4.0 进行许可。